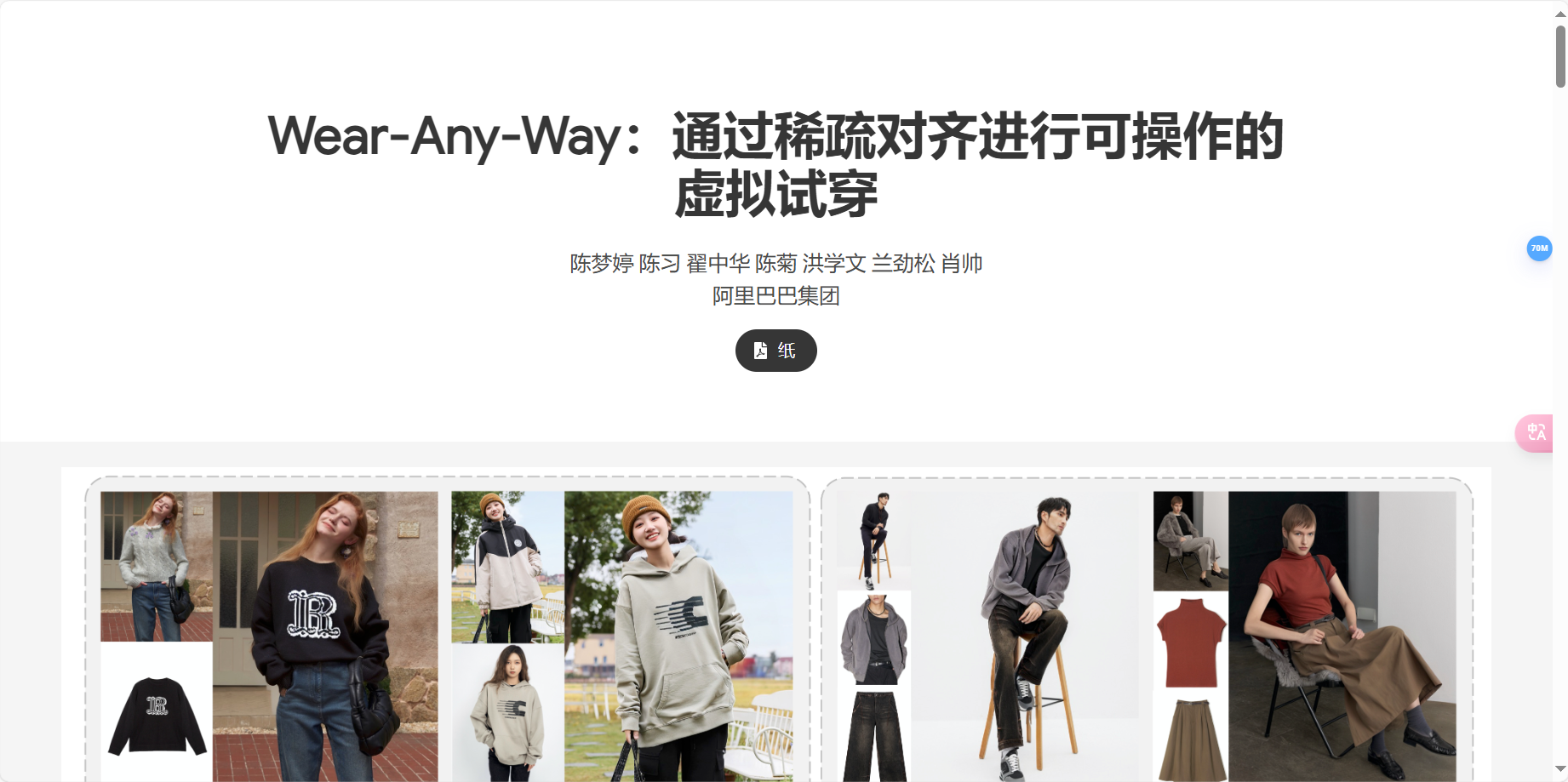

Wear-Any-Way是阿里巴巴推出的一种新颖的虚拟试衣框架。与传统的虚拟试衣方法不同,Wear-Any-Way提供了一种可定制的解决方案,允许用户精确控制试穿风格。这意味着用户不仅可以试穿衣服,还可以根据需要改变衣服的样式,例如卷起袖子或打开外套。这个框架支持多种输入类型,包括商店到模特、模特到模特、商店到街道等,使用户能够同时提供上衣和下衣,并一次性生成试穿结果。Wear-Any-Way的设计基于双U-Net架构,引入了一个稀疏对应对齐模块,使得模型可以定制,为电子商务提供了新颖的功能,并对未来虚拟试戴研究提供了启示。

官网入口:https://mengtingchen.github.io/wear-any-way-page/?ref

Wear-Any-Way的主要功能特点

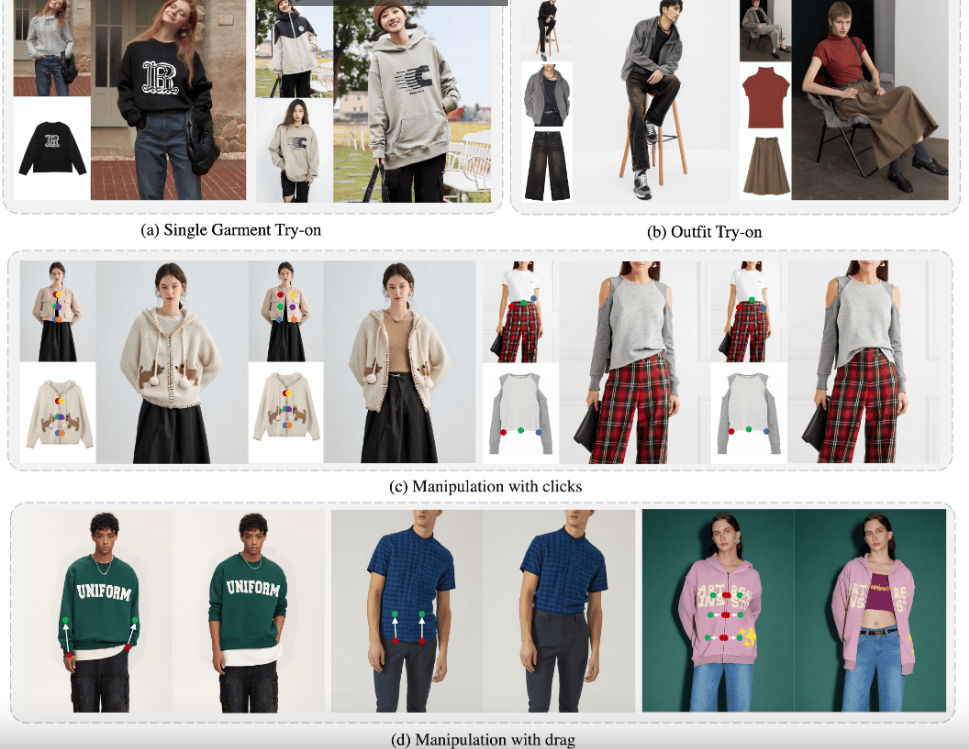

- 高保真度试穿效果:生成的试穿效果质量高,能够在复杂场景中进行单件或多件服装的试穿。

- 精确操纵穿着风格:用户可以通过简单的交互操作,如点击、拖动等,精确控制衣物的穿着方式,包括袖子的卷取、外套的开襟大小甚至tuck的款式。

- 支持多种输入类型:包括商店到模特、模特到模特、商店到街道等,使用户能够在不同的场景下试穿服装。

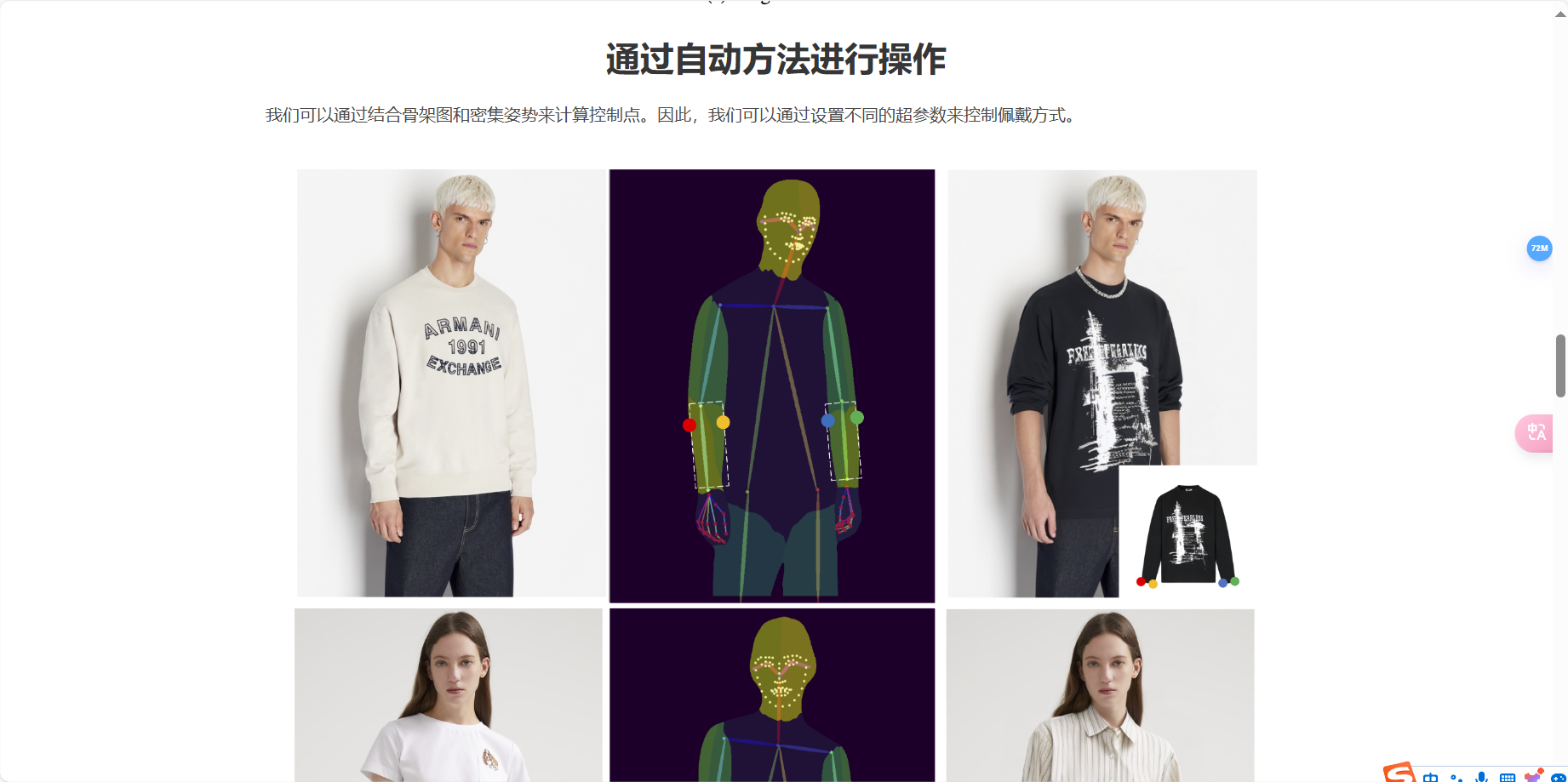

- 稀疏对应对齐:通过基于点的控制来指导特定位置的生成,实现精确的穿戴方式控制。

- 交互式体验:提供了一种新的交互形式,使用户可以自由灵活地表达着装风格。

Wear-Any-Way是否支持多种服装类型?

Wear-Any-Way支持多种服装类型。它不仅支持单件服装的试穿,还支持多件服装的搭配试穿,包括上衣和下衣。此外,Wear-Any-Way能够处理多种输入类型,如平铺图到模特、模特图到模特、平铺图到街拍、模特图到街拍、街拍到街拍等。这意味着无论输入图像是什么形式,或目标模特图的背景姿态如何复杂,Wear-Any-Way都能提供优质的生成结果。这使得Wear-Any-Way成为一个非常灵活和强大的虚拟试衣解决方案,适用于各种不同的时尚场景和需求。

Wear-Any-Way是如何工作的?

- 稀疏对应对齐:通过控制点对引导特定部位的生成,实现对上身状态的精准控制。用户可以通过操作控制点来调整服装的穿着方式,如袖了的挽起或外套的开合。

- 双分支扩散模型:Wear-Any-Wav使用一个主分支和一个参考分支的扩散模型。主分支负责生成图像,而参考分支则提取服装的细粒度特征,以保证服装细节的保真度。

- CUP图像编码器:用于替换文本嵌入,保证服装的整体颜色和大致纹理,同时结合Reerence U-Net来提取服装的细节特征。

- 人体姿势图:作为额外的控制,提高生成效果的准确性。通过小型卷积网络提取姿势图的特征,并将其添加到主U-Net的潜在噪声中。

- 训练策略:包括条件drop、零初始化和点加权损失等优化策略,提高模型对对应关系的学习效率和生成流程的可控性。

©版权声明:如无特殊说明,本站所有内容均为智选AI原创发布和所有。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。否则,我站将依法保留追究相关法律责任的权利。